Po raz pierwszy udało się zsyntetyzować mowę lub mimikę na podstawie sygnałów mózgowych. System może również dekodować te sygnały na tekst z szybkością prawie 80 słów na minutę, co stanowi ogromny postęp w porównaniu z technologią dostępną na rynku.

Edward Chang, lekarz medycyny, kierownik chirurgii neurologicznej na Uniwersytecie Kalifornijskim, który od ponad dziesięciu lat pracuje nad technologią znaną jako interfejs mózg-komputer (BCI), ma nadzieję, że ten najnowszy przełom w badaniach doprowadzi w najbliższej przyszłości do zatwierdzonego przez FDA systemu umożliwiającego mowę na podstawie sygnałów mózgowych.

-Naszym celem jest przywrócenie pełnego, ucieleśnionego sposobu komunikowania się, który jest dla nas najbardziej naturalnym sposobem rozmawiania z innymi – powiedziała Chang, która jest członkiem Instytutu Neuronauki na Uniwersytecie Kalifornijskim UCSF i profesorem Jeanne Robertson Distinguished Professor w Psychiatria. – Te postępy znacznie przybliżają nas do stworzenia realnego rozwiązania dla pacjentów.

Zespół wykazał wcześniej, że możliwe jest dekodowanie sygnałów mózgowych na tekst u mężczyzny, który wiele lat wcześniej również doświadczył udaru pnia mózgu. Obecne badanie pokazuje coś bardziej ambitnego: dekodowanie sygnałów mózgowych na bogactwo mowy wraz z ruchami ożywiającymi twarz osoby podczas rozmowy.

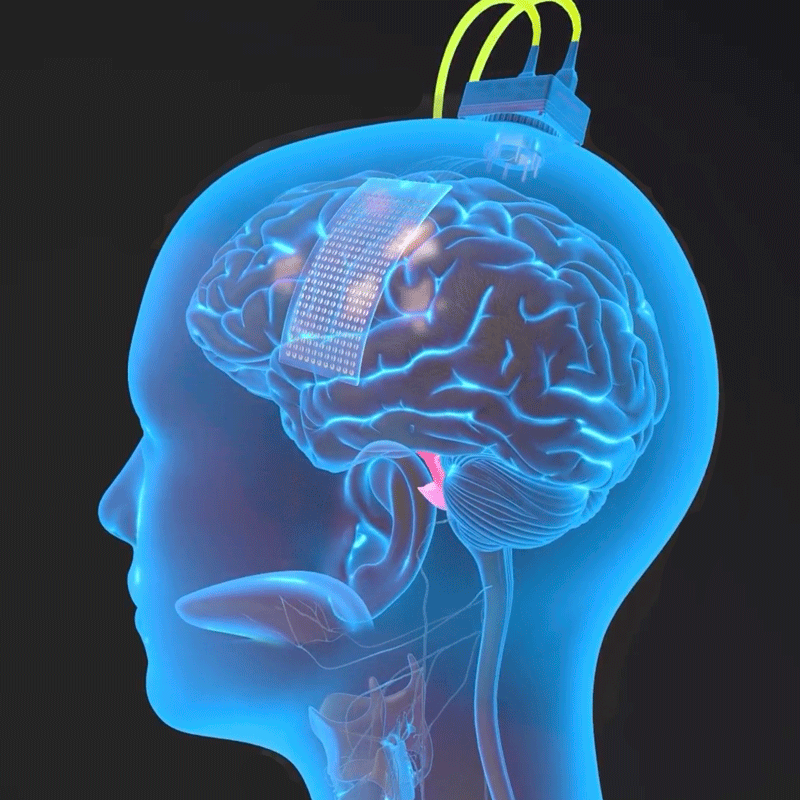

Chang wszczepił cienki jak papier prostokąt, składający się z 253 elektrod na powierzchnię mózgu kobiety w obszarach, które według jego zespołu mają kluczowe znaczenie dla mowy. Elektrody przechwyciły sygnały mózgowe, które gdyby nie udar, dotarłyby do jej mięśni, języka, szczęki i krtani, a także do twarzy. Kabel podłączony do portu przymocowanego do jej głowy łączył elektrody z zespołem komputerów.

Uczestniczka przez tygodnie współpracowała z zespołem nad szkoleniem algorytmów sztucznej inteligencji systemu w zakresie rozpoznawania jej unikalnych sygnałów mózgowych na potrzeby mowy. Wiązało się to z powtarzaniem różnych wyrażeń ze słownictwa konwersacyjnego składającego się z 1024 słów, aż komputer rozpoznał wzorce aktywności mózgu powiązane z dźwiękami.

Zamiast szkolić sztuczną inteligencję do rozpoznawania całych słów, badacze stworzyli system, który dekoduje słowa z fonemów. Są to podjednostki mowy, które tworzą słowa mówione w taki sam sposób, w jaki litery tworzą słowa pisane. Na przykład „Hello” zawiera cztery fonemy: „HH”, „AH”, „L” i „OW”.

Stosując to podejście, komputer musiał nauczyć się jedynie 39 fonemów, aby rozszyfrować dowolne słowo w języku angielskim. Zwiększyło to dokładność systemu i sprawiło, że był on trzykrotnie szybszy.

-Dokładność, szybkość i słownictwo są kluczowe – powiedział Sean Metzger, który opracował dekoder tekstu wraz z Alexem Silvą, absolwentami wspólnego programu bioinżynierii na Uniwersytecie Kalifornijskim w Berkeley i UCSF. „Dzięki temu użytkownik może z czasem komunikować się niemal tak szybko jak my, a także prowadzić znacznie bardziej naturalne i normalne rozmowy”.

Aby stworzyć głos, zespół opracował algorytm syntezy mowy, który spersonalizował tak, aby brzmiał jak jej głos przed kontuzją, wykorzystując nagranie jej przemówienia na weselu.

Zespół animował awatara za pomocą oprogramowania symulującego i animującego ruchy mięśni twarzy, opracowanego przez firmę Speech Graphics zajmującą się animacją twarzy opartą na sztucznej inteligencji. Naukowcy stworzyli spersonalizowane procesy uczenia maszynowego, które umożliwiły oprogramowaniu firmy połączenie się z sygnałami wysyłanymi z mózgu kobiety, gdy próbowała mówić, i przekształcenie ich w ruchy twarzy awatara, powodując otwieranie i zamykanie szczęki oraz wystające usta torebka i język poruszają się w górę i w dół, a także ruchy twarzy wyrażające szczęście, smutek i zaskoczenie.

-Naprawiamy połączenia między mózgiem a przewodem głosowym, które zostały przerwane przez udar – powiedziała Kaylo Littlejohn, absolwentka współpracująca z Changiem i doktorem Gopala Anumanchipalli, profesorem inżynierii elektrycznej i informatyki na Uniwersytecie Kalifornijskim. Berkeley. – Kiedy podmiot po raz pierwszy użył tego systemu do mówienia i jednoczesnego poruszania twarzą awatara, wiedziałem, że to będzie coś, co będzie miało realny wpływ.

Kolejnym ważnym krokiem dla zespołu jest stworzenie wersji bezprzewodowej, która nie wymagałaby od użytkownika fizycznego połączenia z BCI.

– Zapewnienie ludziom możliwości swobodnego kontrolowania własnych komputerów i telefonów za pomocą tej technologii miałoby głęboki wpływ na ich niezależność i interakcje społeczne – powiedział współautor, dr David Moses, adiunkt w dziedzinie chirurgii neurologicznej.

Tekst: materiały prasowe Uniwersytetu Kalifonijskiego – San Francisco, zdjęcie zajawka: Noah Berger , ilustracja: Ken Probst

Zostaw komentarz

You must be logged in to post a comment.