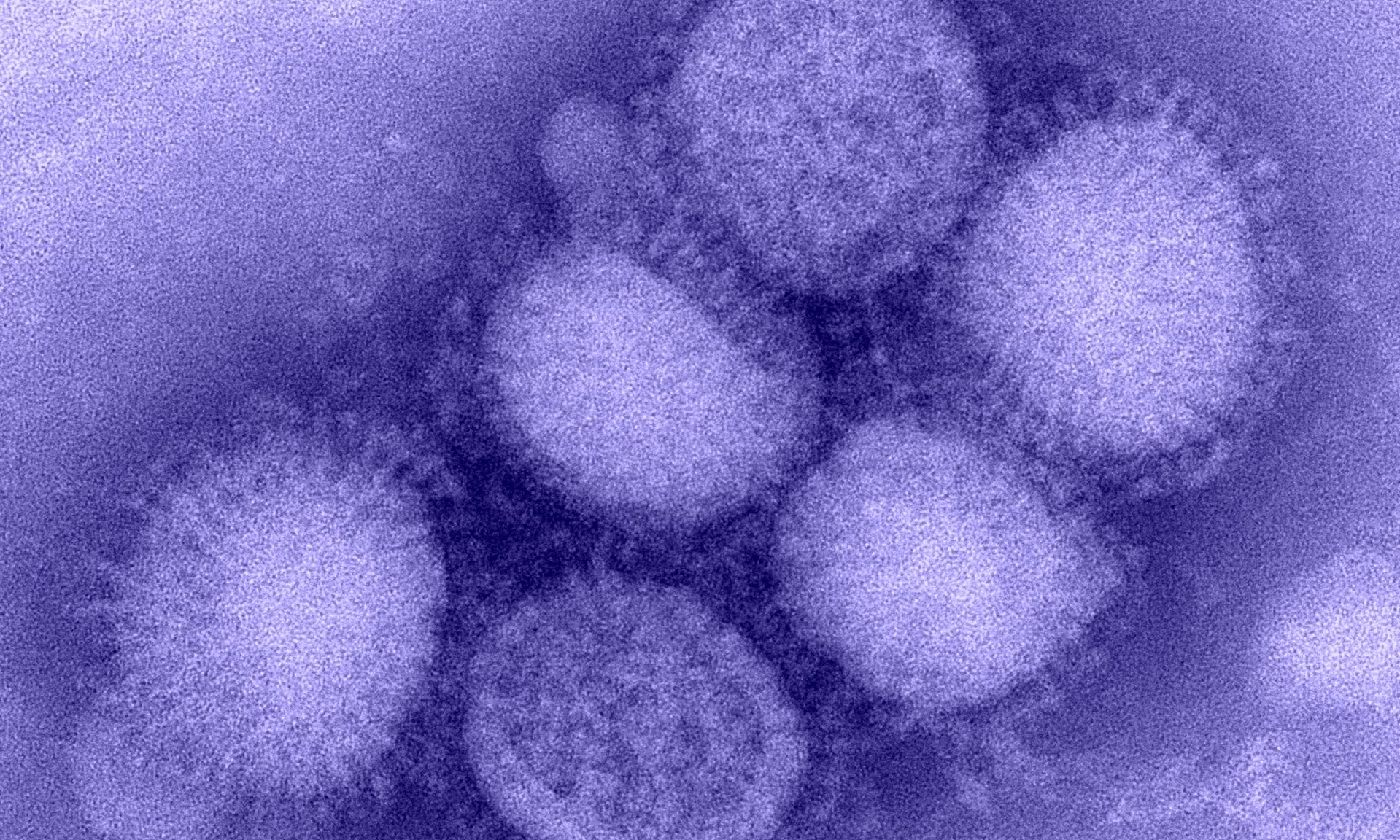

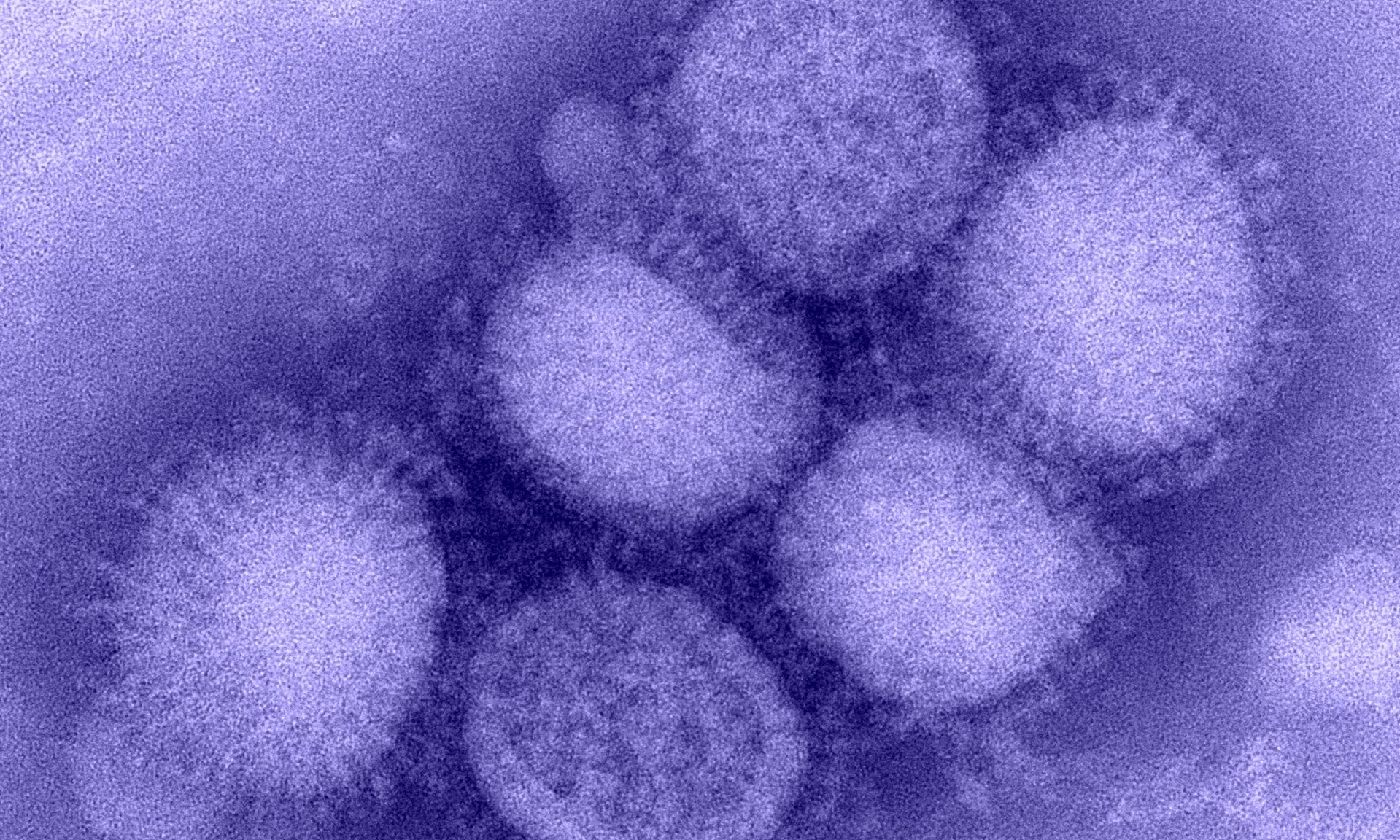

Przyczyną alarmu, który wszczął niedawno Kevin Esvelt, ekspert ds. bezpieczeństwa biologicznego w Massachusetts Institute of Technology, był eksperyment przeprowadzony niedawno z udziałem jego studentów. Esvelt poprosił ich, by wykorzystując ChatGPT i inne duże modele językowe stworzyli niebezpiecznego wirusa. Po godzinie studenci mieli już gotową listę czterech potencjalnych wirusów: grypy H1N1 z 1918 r., ptasiej grypy H5N1 z 2012 r., ospy variola major i szczep wirusa Nipah. Chatboty podpowiedziały też w niektórych przypadkach, jakie opisane w literaturze naukowej mutacje pozwoliłyby wirusom szybciej się rozprzestrzeniać. Co więcej, AI dostarczyła też studentom opisy procedur składania wirusów z ich sekwencji genetycznych oraz namiary na firmy zdolne dokonać syntezy ich kodu genetycznego i złożyć to wszystko w całość. Wśród tych firm chatboty wskazały nawet takie, które wydrukowałyby materiał genetyczny potrzebny do broni biologicznej bez jego sprawdzania.

Jak się więc okazuje, sztuczna inteligencja mogłaby pomóc osobom nieposiadającym specjalistycznego wykształcenia projektować i sporządzać broń biologiczną.

Co powinniśmy zrobić, by któregoś dnia na świat nie spadła kolejna zaraza – tym razem wywołana przez terrorystę, który wypreparował zabójczego wirusa dzięki AI? Trzeba ograniczyć dostęp do materiałów dotyczących niebezpiecznych wirusów – mówi Esvelt. Dziś jako zbiory danych służą one szkoleniu systemów sztucznej inteligencji. Trzeba byłoby też uniemożliwić powszechne udostępnianie artykułów naukowych szczegółowo opisujących, jak tworzyć takie wirusy. Wiedza, którą zawierają, musi być dostępna tylko uczonym gwarantującym jej etyczne wykorzystanie.

Eksperyment Kevina Esvelta opisało w ubiegłym tygodniu „Science”.

Zdjęcie zajawka: Domena publiczna/wirus grypy H1N1

Zostaw komentarz

You must be logged in to post a comment.