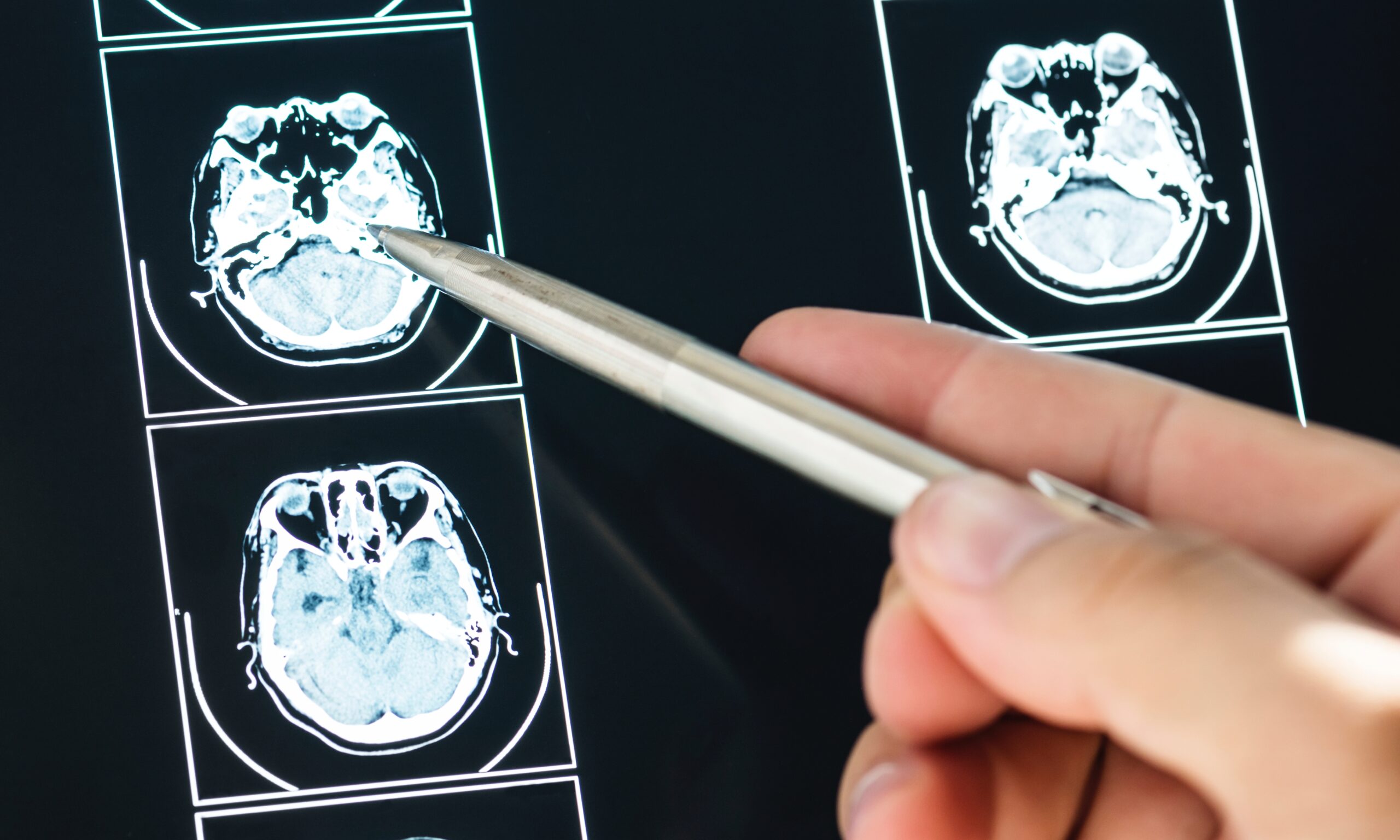

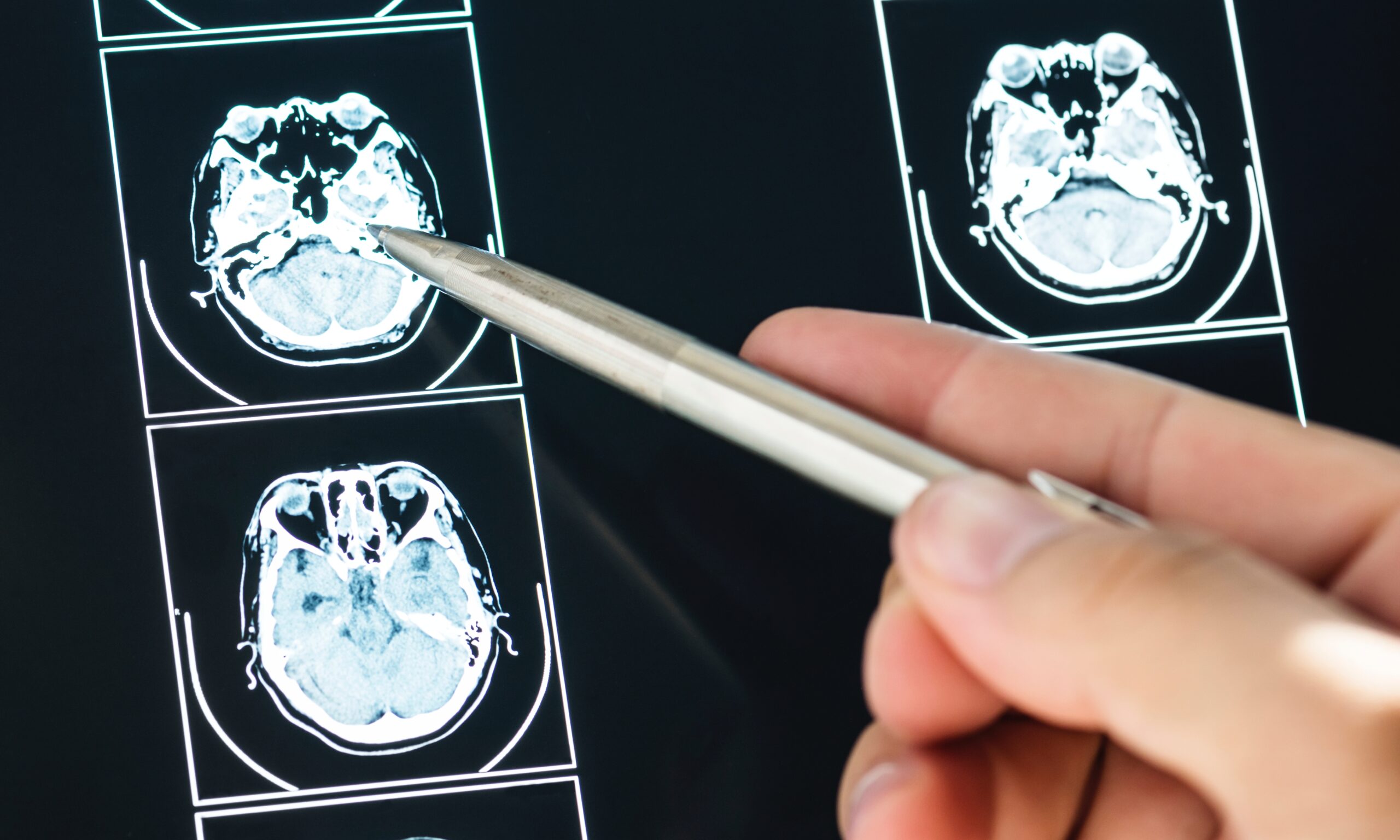

Badacze zaprosili sztuczna inteligencję na egzamin z radiologii. Chcieli tym samym zbadać mocne i słabe strony AI. Naukowcy wykorztstali popularną wersję ChatGPT w oparciu o GPT-3.5, a następnie GPT-4. Zastosowali treść i poziom trudności egzaminów Canadian Royal College i American Board of Radiology.

-Wykorzystanie dużych modeli językowych, takich jak ChatGPT, rośnie i będzie rosło – powiedział główny autor, dr Rajesh Bhayana, radiolog z University Medical Imaging w Toronto (Kanada). – Nasze badania dają wgląd w możliwości ChatuGPT w kontekście radiologii, podkreślając niesamowity potencjał dużych modeli językowych, wraz z obecnymi ograniczeniami, które czynią go niewiarygodnym.

Pytania nie zawierały obrazów i zostały tak pogrupowane, aby ocenić prostsze i trudniejsze czynności myślowe. ChatGPT -3.5 udzielił prawidłowych odpowiedzi na 69 proc. pytań.

W kolejnym badaniu wzięli na tapetę GPT-4. Model odpowiedział poprawnie na 81 proc. tych samych pytań,. GPT-4 działał lepiej niż GPT-3.5 w przypadku bardziej skomplikowanych pytań. A przecież mamy już jeszcze wyższa wersję GPT.

-Nasze badanie pokazuje imponującą poprawę wydajności ChatGPT w radiologii w krótkim okresie, podkreślając rosnący potencjał dużych modeli językowych w tym kontekście – stwierdził dr Bhayana.

GPT-4 nie wykazał poprawy w przypadku łatwiejszych pytań i odpowiedział niepoprawnie na 12 spośród tych, na które GPT-3.5 odpowiedział poprawnie. Stąd pytania o jego wiarygodność w zakresie gromadzenia informacji.

-Początkowo byliśmy zaskoczeni dokładnymi i pewnymi odpowiedziami GPT na niektóre trudne pytania, ale potem równie zaskoczeni niektórymi bardzo nielogicznymi i niedokładnymi twierdzeniami – powiedział dr Bhayana.

Wnioski z badania? Pomimo braku wstępnego szkolenia w zakresie radiologii, ChatGPT prawie zdał egzamin w stylu radiologii bez obrazów; dobrze radził sobie z pytaniami dotyczącymi myślenia niższego rzędu i pytaniami dotyczącymi postępowania klinicznego, ale miał problemy z pytaniami dotyczącymi myślenia wyższego rzędu, obejmującymi opis wyników badań obrazowych, obliczenia i klasyfikację oraz zastosowanie pojęć.

Niebezpieczne działanie ChatuGPT w generowaniu niedokładnych odpowiedzi jest rzadsza w wersji GPT-4, ale wciążogranicza jego użyteczność w edukacji medycznej i praktyce klinicznej.

Oba badania wykazały, że ChatGPT konsekwentnie wypowiadał się w sposób wskazujący, że jest czegoś pewien, nawet jeśli nie miał racji.

-Dla mnie jest to jego największe ograniczenie. Obecnie ChatGPT najlepiej nadaje się do pobudzania pomysłów, pomagania w rozpoczęciu procesu pisania medycznego i podsumowywania danych. Jeśli jest używany do szybkiego przywoływania informacji, zawsze musi być zweryfikowany – stwierdził dr Bhajana na łamach czasopisma Radiology.

Więcej informacji dot. tych badań znajdują się TU

Zdjęcie zajawka: rawpixel.com

Zostaw komentarz

You must be logged in to post a comment.